Die unsichtbare Front

10. November 2025

18. August 2025

Desinformationen beeinflussen seit Menschengedenken die öffentliche Meinungsbildung. Neu ist, wie schnell und täuschend echt sie heutzutage viral gehen. Inzwischen kann fast jeder mit Hilfe von Künstlicher Intelligenz (KI) und ein bisschen Übung authentisch wirkende Bilder generieren oder Ton- und Videoaufnahmen manipulieren. Was bedeutet das für unsere Demokratie und Sicherheit?

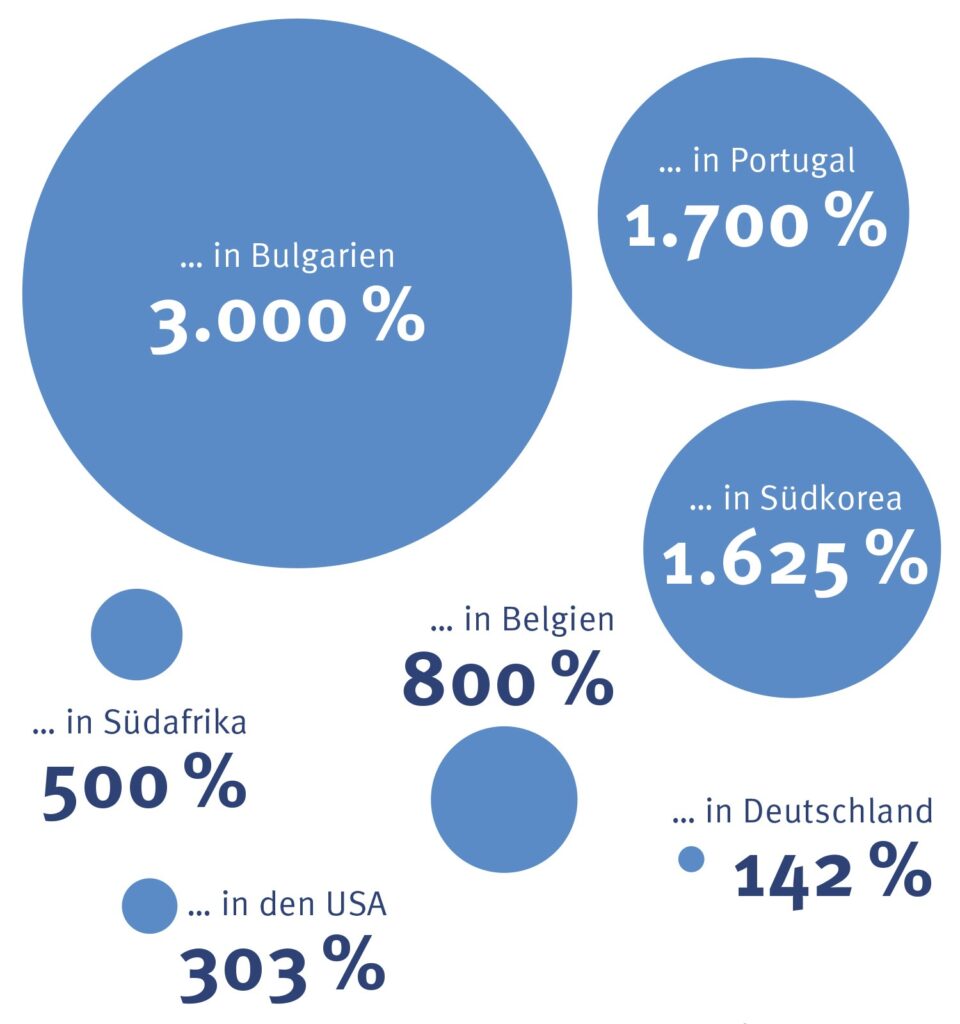

Deep Fakes in Zahlen

Anstieg von Deep Fakes in Ländern mit Wahlen im Jahr 2024 …

Quelle: Sumsub Data Reports

ZDF-Moderator Christian Sievers wirbt angeblich für zweifelhafte Geldanlagen, der deutsche Bundeskanzler Friedrich Merz verachtet in einem Statement die Demokratie und die US-amerikanische Pop-Ikone Taylor Swift wird mit gefälschten pornographischen Bildern kompromittiert. Deep Fakes wie die genannten Beispiele kursieren massenweise im Netz. Dabei handelt es sich um manipulierte Bild-, Video- oder Audiodateien, die mit Hilfe von künstlichen neuronalen Netzen und Methoden des mehrschichtigen Lernens (Deep Learning) erzeugt werden. Die dazu nötigen Werkzeuge sind frei verfügbar. Je mehr Daten die KI über das Aussehen, die Mimik und Gestik der betroffenen Personen erhält, desto authentischer und echter wirken die computergenerierten Fälschungen.

Lange Tradition

Den Kontext weglassen, Fakten verändern, Lügen in die Welt setzen: Fake News sind kein neues Phänomen. Ihre Geschichte reicht mehr als 2.000 Jahre zurück. Bereits seit der Antike werden Desinformationskampagnen genutzt, um politische Gegner zu diskreditieren, sich finanzielle Vorteile zu verschaffen, die Öffentlichkeit zu verunsichern oder Misstrauen, Angst und Wut zu schüren. Mit den heutigen Möglichkeiten, die soziale Medien und KI-Technologien eröffnen, erreichen Desinformationen allerdings eine neue Dimension.

Identitätsbetrug steigt rasant

Laut des Anfang 2025 veröffentlichten Identity Fraud Report des Entrust Cybersecurity Institute fand im vergangenen Jahr alle fünf Minuten ein Deep-Fake-Angriff statt. Die Zahl gefälschter digitaler Dokumente und Identitäten ist im Vergleich zu 2023 um 244 Prozent gestiegen. Gleichzeitig werden die Betrugsmaschen immer raffinierter. Beim Luxusautohersteller Ferrari ereignete sich ein besonders aufsehenerregender Fall. Mit einer perfekt imitierten, KI-generierten Stimme des Vorstandsvorsitzenden Benedetto Vigna versuchten Cyberkriminelle, eine hohe Geldüberweisung zu veranlassen. Der kontaktierte Manager wurde misstrauisch. Andere Unternehmen wie eine Tochterfirma des Zahlungsanbieters Paypal oder der US-amerikanische Netzwerkkomponentenhersteller Ubiquity Networks hatten weniger Glück.

Propagandawaffe der Zukunft

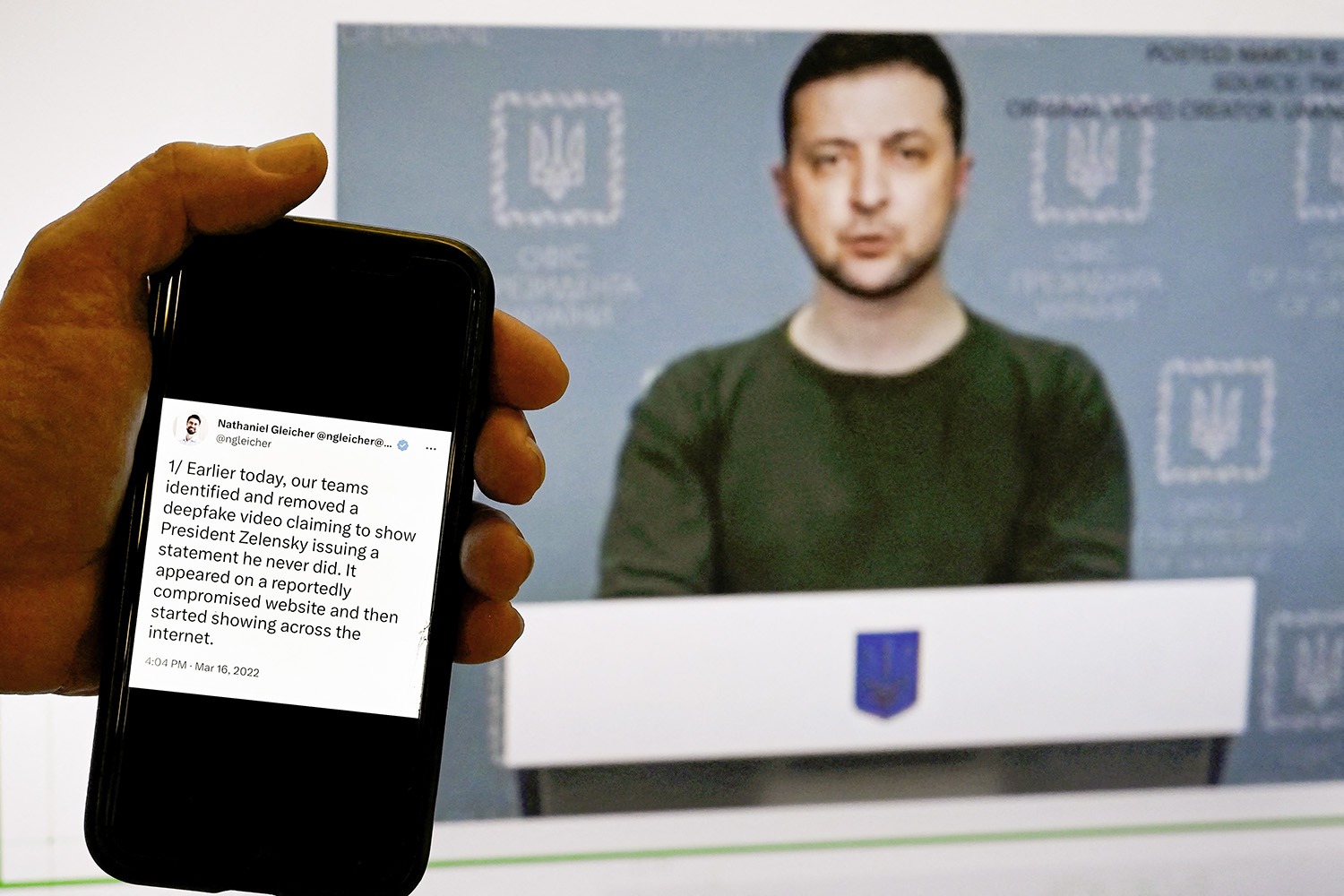

Doch nicht nur für Unternehmen stellen Deep Fakes eine wachsende Bedrohung dar. Mit der zunehmenden Verbreitung der gefälschten Ton- und Videoaufnahmen steigt auch die Gefahr der politischen Einflussnahme – bei Wahlen, öffentlichen Diskursen und staatlichen Konflikten. Bereits im März 2022 erschien ein angebliches Kapitulationsvideo des ukrainischen Präsidenten Wolodymyr Selenskyj. Ließen sich solche Deep Fakes der ersten Generation noch relativ einfach entlarven, ist das bei den heutigen hochwertigen Fälschungen um ein Vielfaches schwerer. Welche aktuellen Augenzeugenberichte aus den Kriegsgebieten sind echt, welche gefälscht?

Vertrauensverlust

Deep Fakes säen Zweifel am Wahrheitsgehalt von Nachrichten, befeuern Konflikte und demoralisieren. Sie untergraben das Vertrauen in demokratische Institutionen und tragen zur Polarisierung und gesellschaftlichen Spaltung bei. Je mehr Ärger eine Nachricht auslöst, desto größer die Chance, dass Menschen darauf reagieren – und damit in den sozialen Netzen Reichweite erzielen. Ein weiterer Effekt ist die sogenannte Lügen-Dividende: Der durch Deep Fakes verursachte Vertrauensverlust macht es Autokraten und populistischen Parteien umso einfacher zu behaupten, echte Videos seien gefakt.

Deep Fakes gezielt bekämpfen

Um die Risiken durch Deep Fakes zu minimieren, ist eine fundierte Digitalkompetenz entscheidend. Verdächtige audiovisuelle Medien sollten kritisch hinterfragt und über andere Quellen überprüft werden. Gleichzeitig helfen KI-gestützte Erkennungssysteme und robuste Sicherheitsprotokolle.

Klicken Sie hier, um Push-Benachrichtigungen zu empfangen. Durch Ihre Einwilligung erhalten Sie regelmäßige Informationen zu neuen Beiträgen auf der Dimensions-Webseite. Dieser Benachrichtigungsservice kann jederzeit in den Browser-Einstellungen bzw. Einstellungen Ihres Mobilgeräts abbestellt werden. Ihre Einwilligung erstreckt sich ausdrücklich auch auf eine Datenübermittlung in Drittländer. Weitere Informationen finden Sie in unserer Datenschutzinformation unter Ziffer 5.